irgendwann vor ca. einem Jahr begann es: in meiner "Umgebung" verschwanden die Geburtstage im Google Kalender. Offenbar kein Einzelfall, sondern von langer Hand geplant, wie der Artikel bei Heise zeigt. Der Workaround im Artikel hat damals funktioniert, mittlerweile nicht mehr. Verstanden habe ich die ganze Sache gar nicht - vor allem warum es noch nie eine gute Idee gewesen sein soll, den Geburtstag beim Kontakt zu speichern - ich vermute ja: das ist die Rache von Google am kleinen Mann.

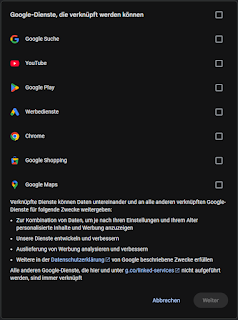

Interessant daran ist: nach einem knappen Jahr taucht der nächste Fall auf und es gibt eine Besonderheit: Mein Geburtstagskalender funktioniert ohne Zutun immer noch, aber die im Artikel gezeigten "verknüpften Dienste" sehen anders aus, bei mir fehlen die Kontakte und Wallet Dienste. Ich bin argwöhnisch und habe alle Haken entfernt, ohne einen Nachteil zu spüren!

Im Oktober 24 erschien ein Beitrag auf Caschys Blog, der bisher nachhaltig funktioniert. Allerdings ist die Anleitung dort etwas kurz geraten. Deswegen meine Ergänzung: